반응형

Feature Normalization & Softmax

이 포스팅들은 기초 ML 이론을 정리하는 목적으로 쓰는 것이므로, 글의 완성도가 조금 떨어질 수 있다.사실 두가지 주제가 딱히 관련이 있진 않지만, 분량이 애매해서 2개를 묶어서 포스팅을 진행하게 되었다.

Normalization

- Normalization은 서로 다른 Feature의 분포를 모두 동일한 기준으로 맞춰줌으로써 보다 빠르게 Convergence가 일어날 수 있도록 하는데에 의의가 있다.

- 위 그림은 Gradient Descent 과정에서 Normalization의 중요성을 여실히 보여준다.

- Normalization 방법은 대표적으로 Min-Max Normalization과 Z-score Normalization이 존재한다.

- Mix-Max Normalization

- 최소-최대 정규화 (0, 1 사이로 맞춰줌)

import numpy as np X = np.array([[10., -10., 1.],[5., 0., 2.],[0., 10., 3.]]) X_minmax = (X - X.min(axis=0)) / (X.max(axis=0) - X.min(axis=0)) - Z-score Normalization

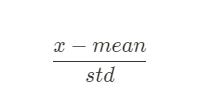

- 평균과 표준편차를 사용하여 정규화

import numpy as np X = np.array([[10., -10., 1.],[5., 0., 2.],[0., 10., 3.]]) X_zscore = (X - X.mean(axis=0)) / X.std(axis=0)

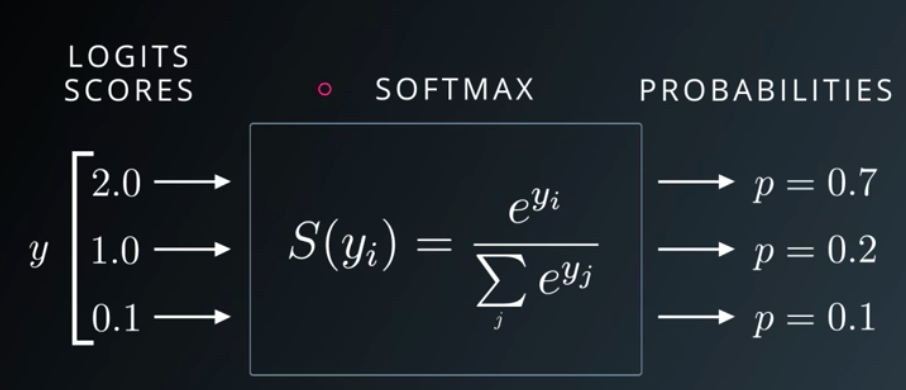

SoftMax

- 분류해야 하는 클래스의 총 개수가 k개일 때, k차원의 벡터 Z를 입력받으면, 각 클래스에 대한 확률값 P를 리턴해주는 함수이다.

- 총 확률값의 합은 언제나 1이 나오도록 맞춰준다.

반응형

'Machine Learning > ML기초' 카테고리의 다른 글

| [ML 이론] Evaluation Metric 정리 (0) | 2021.12.20 |

|---|---|

| [ML 수학] Kullback Leibler Divergence(KL Divergence, Cross Entropy) (0) | 2021.12.16 |