[논문 리뷰] ResNeXt : Aggregated Residual Transformations for Deep Neural Networks

Machine Learning/Deep Learning 논문 2021. 10. 18. 00:36반응형

ResNeXt: Aggregated Residual Transformations for Deep Neural Networks

Kaiming He의 또 다른 논문, ResNeXt를 리뷰해보자.

연구의 배경

- 시각 데이터를 다루는 연구들은 이제 단순히 Feature를 잘 처리하는 Feature Engineering 뿐만 아니라, 효율적으로 학습이 가능하도록 Network 설계를 잘 만드는 Network Engineering으로 전환됨

- 하지만 Architecture를 설계하는 것은 매우 어려운 일인데, 그러한 원인 중 한 가지는 하이퍼 파라미터의 수가 점점 늘어남에 따라 연구자들이 여러가지 Task에 대해서 적절한 하이퍼 파라미터를 설정하는게 어렵기 때문이다.

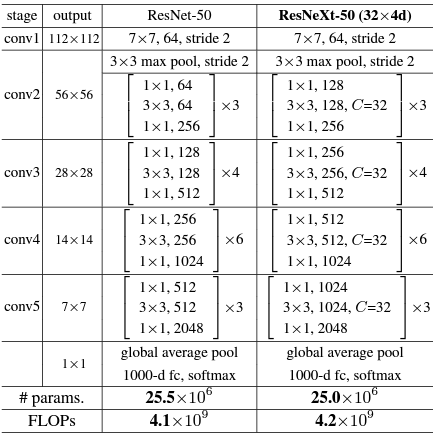

- ResNeXt는 ResNet을 계승받아 항상 일정한 형태를 가지는 Convolution층 여러개를 쌓아서 만들어지며(Residual Block), 이로 인해 레이어별로 Kernel Size를 어떻게 할지와 같은 고민으로부터 연구자들을 해방시킬 수 있다.

- 또한 Inception 모델들이 가지는 주요 특성인 Split-Transform-Merge의 특성을 적용하여 높은 정확도를 얻었다.

Split - Transform - Merge

- ResNeXt의 핵심은 ResNet 구조의 Architecture에 Inception에서 사용하던 Cardinality 개념을 도입하여 Convolution 연산을 쪼개서 진행하고, 서로 다른 Weight를 구한뒤 합쳐주는 Split-Transform-Merge를 추가한 것이다.

- 이 때, 쪼개진 CNN이 몇개의 path를 가지는지를 결정하는 하이퍼파라미터가 바로 Cardinality이며, 각각의 path에서 가지는 채널을 depth라고 정의한다.

- 따라서 위 그림은, Conv2 Stage 기준 32개의 path와 4의 사이즈를 가지므로, Cardinality = 32, detph = 4의

ResNeXt-50 (32x4d)로 정의할 수 있다.

- ResNet과의 구조 차이는 위 그림과 같다.

실험 결과

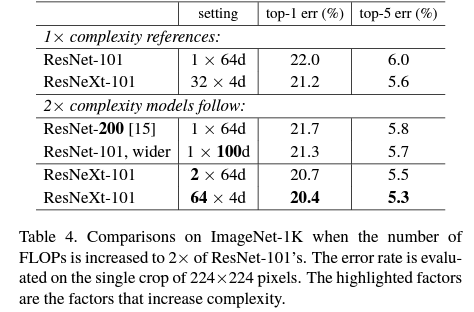

- ResNeXt가 Inception의 Split - Transform - Merge 개념을 도입한 것 만으로도 ResNet을 상회하는 성능을 가지게 되었다.

- 저자는 실험을 통해, 모델의 깊이를 늘리거나, 채널을 늘리는 것보다 단순히 Cardinality를 올림으로써 가장 적은 계산량증가로 최대의 성능 향상 효용을 얻을 수 있다고 설명했다.

- 실제로 Cardinality를 64로 설정한 ResNeXt-101이, ResNet200과 ResNet-101에서 채널을 100으로 늘린 네트워크보다 더 좋은 성능을 보이는 것을 확인할 수 있다.

반응형

'Machine Learning > Deep Learning 논문' 카테고리의 다른 글

| [논문 리뷰] Attention Is All You Need(Transformer) (0) | 2021.12.12 |

|---|---|

| [논문 구현] Pytorch 기반 ResNeXt 구현 및 CIFAR10 실험 (0) | 2021.10.18 |

| [논문 구현] Pytorch 기반 VGG 구현 및 CIFAR10 실험 (3) | 2021.10.16 |

| [논문 구현] Pytorch 기반 ResNet 구현 및 CIFAR10 실험 (0) | 2021.10.14 |

| [논문 리뷰] ResNet : deep residual learning for image recognition (0) | 2021.10.13 |